Umělá inteligence zažívá boom. Intel vyvíjí čipy určené přímo pro neuronové sítě, Google i Microsoft vynakládají hodně úsilí na strojové učení. Příkladem umělé inteligence je třeba překladač jazyků, počítačový hráč pokeru nebo analýza bezpečnosti. |

„Soudce MetaDecide57 rozhoduje ve vašem případu. Čekejte, prosím, rozsudek může několik sekund trvat.“ Že by konec dlouhým čekacím lhůtám a nekonečným soudním tahanicím? Možná. A možná také začátek revoluce, která promění náš pohled na právo, soudy a spravedlnost.

Nejedná se přitom o nějakou akademickou debatu. Samotný předseda Nejvyššího soudu Spojených států amerických, John G. Roberts, byl tázán, zda si dovede představit den, kdy bude umělá inteligence využívána i v soudnictví. „To je den, který už nastal,“ odpověděl. „A vytváří to výrazný tlak na fungování soudnictví.“ Jedním případem, který se v této souvislosti často zmiňuje, je odsouzení Američana Erica Loomise na šest let odnětí svobody za řízení kradeného auta, které bylo použito při přestřelce.

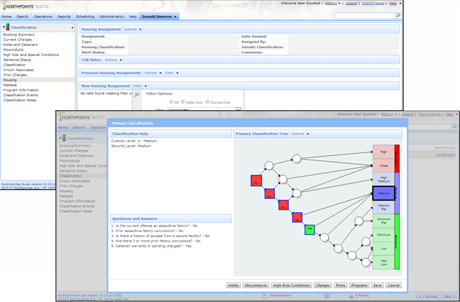

Ukázka programu Compas, který nabízí tyto funkce: klasifikace vězňů, posuzování dynamiky chování vězňů, generování hlášení v reálném čase, asistence při rozhodování a posuzování rizik

K podpoře tohoto rozsudku totiž byl využit i výstup z programu Compas od společnosti Northpointe, který slouží ke klasifikaci a analýze vězňů. Podle žalobce tento software poukázal na to, že obžalovaný vykazuje velké riziko násilného chování a recidivy. Soudce mu pak oznámil, že byl na základě zhodnocení Compasu identifikován jako někdo, kdo je „vysokým rizikem pro komunitu.“ Není přesně známo, co tento výstup obsahoval, ale prý v něm byly zahrnuty grafy znázorňující riziko, že obžalovaný provede další zločin. Problematická je hlavně další neznámá věc: na základě čeho program ke svému závěru došel.

Tajné algoritmy skýtají prostor pro diskriminaci i omyly

Compas je totiž proprietární software a nikdo vyjma jeho tvůrců nemá přístup k algoritmům, na nichž je založen. Základem mají být data ze 137 otázek, které jsou položeny obžalovanému, například „Byl některý z tvých rodičů poslán do vězení?“ nebo „Kolik z tvých přátel bere nelegální drogy?“ Obsahuje také otázky, zda souhlasí s výroky jako „Pokud je člověk hladový, má právo dopustit se krádeže.“ Není ale jasné, jak se následně s odpověďmi pracuje a zda nejsou pro analýzu použity i další údaje.

Algoritmus a rasaČasto citovaným zjištěním bylo také to, že odhady se zdály být silně ovlivněny rasou obžalovaného. Ti černošští měli téměř dvakrát vyšší pravděpodobnost, že u nich bude předpovězen budoucí zločin, kterého se nedopustí. U bělochů to fungovalo naopak a Compas riziko zřejmě podhodnocoval. Společnost Northpointe se proti těmto zjištěním ohradila. Odmítla ale zveřejnit kód programu. |

Server ProPublica nicméně provedl vzhledem k podezření na přesnost a nezaujatost predikcí vlastní analýzu. Porovnal „skóre rizika“ Compasu více než 7000 zatčených lidí s tím, zda se opravdu do dvou let dopustili zločinu. Co se týče násilného zločinu, Compas se ukázal zcela nespolehlivý: jen 20 % lidí vyhodnocených jako rizikových se násilného zločinu skutečně dopustilo. U nenásilných zločinů byla úspěšnost o poznání vyšší, software se trefil v 61 % případů - ani to však není zrovna přesvědčivé číslo vzhledem k tomu, že program může pomoci poslat někoho za mříže.

Obhájci odsouzeného Loomise právě kvůli tomuto nejasnému základu analýzy tvrdí, že bylo porušeno jeho právo na řádný proces. Nemohou totiž vědět, jak algoritmy fungují a ani napadnout případné nesrovnalosti. Soudce tvrdí, že by k rozsudku dospěl bez ohledu na analýzu Compasu: odsouzený před policisty utíkal a měl předchozí zápis v trestním rejstříku. Jak ale podotýká Christopher Markou z Cambridgeské univerzity, neovlivněním soudce si nemůžeme být jistí. Podobné doporučení od důvěryhodně působícího programu může naše úsudky ovlivnit, ať chceme, nebo ne.

Ani umělá inteligence není bez předsudkůProgramy jako Compas mají sloužit k tomu, aby umožnily soudcům dělat lepší rozhodnutí, která budou založena na jasných datech, nikoli na předsudcích a dojmech. Jelikož jsou ale algoritmy psány přímo programátory, snadno se v nich pak ocitnou různé předsudky, vůči kterým měly tyto algoritmy pomoci. Využití samostatně se učící umělé inteligence by zde mělo být lepší: ta by neměla být předsudky ovlivněna. Jak si v Science všímá Matthew Hutson, nemusí to tak ale vůbec být. Programy se totiž učí zpravidla na reálných lidských rozhodnutích: například význam slov se učí tak, že analyzují texty dostupné na webu a zjišťují tak, s jakými jinými slovy se nejčastěji pojí. Výzkumníci na Stanfordské univerzitě ve studii, kdy se software „učil“ analýzou stovek miliard slov na webu, zjistili, že stroj přejal i řadu rasových a genderových předsudků přítomných v těchto textech. Typickou ukázkou byla svého druhu slavná hláška vyhledávače Google. Pokud jste hledali „she invented“ (vynalezla), nabídl opravu překlepu na „he invented“ (vynalezl), protože lidé častěji vyhledávali právě vynálezce-muže. Textová analýza může ale stejně tak sloužit k odchytávání těchto - často neuvědomovaných - stereotypů, které mohou bránit například uchazečům ztotožnit se s určitým povoláním. |

Server Wired pak zachází v úvahách ještě dál a přemýšlí právě nad tím, jak využívání softwaru pro tyto účely stanovuje precedent pro další vývoj - až nebudou používány lidmi naprogramované algoritmy, které jdou přezkoumat, ale pokročilejší přístupy, například neuronové sítě. Ty sice programátoři navrhnou, ale program se již pak učí z velké části sám. V případě použití takového softwaru by se už velmi špatně pátralo po tom, jak v daném případě postupoval při určování rizika. Jeho tvůrci by mohli vysvětlit, jak byl software navržen a na jakých datech se „učil“, ale ne již, jak dospěl k samotnému rozhodnutí. Pokud přistoupíme na to, že postup například v Loomisově případě byl v pořádku, pak by soudům nezbývalo než odevzdat část rozhodování nejasnému úsudku takovéto černé skříňce, neprůhledné umělé inteligenci, varuje Wired. Možným, avšak nikterak jednoduchým řešením je „donutit“ černou skříňku, aby své rozhodnutí srozumitelně zdůvodnila a podložila argumenty a využitými daty.

„Umělá inteligence by z práva mohla udělat neprůhlednou černou skříňku. Tomu je třeba razantně vzdorovat.“ Christopher Markou, University of Cambridge |

Vytvořit čistě neutrální umělou inteligenci tedy může být mnohem náročnější, než se zdá. Využití podobných algoritmů přímo u soudu tak může napáchat více škody než užitku. Zejména v současné podobě, kdy se využívají uzavřené programy, podle Markoua představuje zneprůhlednění soudního systému, kterému je potřeba silně vzdorovat: „Je to cesta k tomu, jak z právního procesu udělat černou skříňku. Tomu je třeba razantně vzdorovat.“

Jiné příklady zapojení počítačových algoritmů naopak ukazují, jak může umělá inteligence, statistika nebo matematika pomoci napravovat křivdy a nespravedlivé předsudky. „Kdyby existoval program jako Compas, který by byl open-source a bylo by možné ověřit, jak došel ke svým závěrům, bylo by to zlepšení,“ souhlasí Markou. „Umělá inteligence nabízí řadu skutečných příležitostí, možností, jak zlepšit život pro všechny. Ale musíme se vždy ptát, jak je umělá inteligence v právu používána, za jakým účelem a jaký máme nad tímto použitím dohled.“

Příkladem takového algoritmu, který jasně ukazuje, jak funguje, je třeba práce amerických vědců (PDF) poukazující na často nespravedlivě navržené hranice soudních okrsků (tzv. gerrymandering). Jejich algoritmus načrtne miliony možných férových rozdělení státu na okrsky a poté další miliony možných rozdělení, které cíleně zvýhodňují jednu či druhou politickou stranu. Porovnáním výsledků těchto simulací se skutečným rozvržením, které navrhla komise, pak lze posoudit, zda komise postupovala férově, nebo měla postranní motiv, což lze použít jako důkaz u soudu, pokud se k němu dostane stížnost na neférově rozdělené volební okrsky (více o této problematice zde).

Spravedlnost má být slepá, praví slavná právnická poučka. Odkazuje na princip nestrannosti a nezaujatosti soudce, který má ve věci sporu rozhodovat bez ohledu na to, o kom rozhoduje. Tato nezaujatost je nesmírně složitá, neboť v praxi není možné zcela odhlédnout od jednotlivostí daného případu. Soudce či porotce tak musí sahat do svého svědomí a hlídat sám sebe, zda a proč rozhoduje, a své rozhodnutí zdůvodnit. Počítačový soudce by teoreticky mohl tuto nestrannost zaručit mnohem lépe, neboť by - opět teoreticky - bylo možné jasně definovat, která kritéria nesmí brát v potaz. V praxi bude zřejmě právě toto velkou výzvou do budoucna - zajistit, aby spravedlnost v podání umělé inteligence byla slepá, ačkoli uvidí téměř vše.

Umělá inteligence není v justici žádným nováčkem

102,4 milionu případů V roce 2006 se jen v USA k soudům dostalo podle oficiálních statistik přes sto milionů případů |

Přestože si to zřejmě řada lidí neuvědomuje, robotický právník už dávno není jen vize sci-fi spisovatelů nebo akademických diskuzí. Počítačové programy už po desetiletí pomáhají právníkům analyzovat dokumenty, prohledávat zákony, předpisy i předchozí kauzy. To je zvláště důležité v právních systémech vyznávajících precedentní právo. Právě zde se právníkům - obhájcům i žalobcům - nesmírně hodí pomoc umělé inteligence, která dokáže prohledat stovky milionů soudních případů.

Robotický právník, nebo spíše právní koncipient, z dílny IBM (reklamní video):

Podívejme se na nejzajímavější příklady „robotických právníků“, kteří pomáhají svým lidským kolegům při přípravě na soudní řízení:

- Ross - robotický právník využívá umělou inteligenci IBM Watson k analýze dokumentů v databázi případů, zákonů a právních názorů. Právníci z desítky prestižních firem, které jeho služeb využívají, se mohou Rosse zeptat celou větou na otázku a on se pokusí odpovědět na základě analýzy dat a „porozumění“ významu textu.

- Lex Machina - statistický nástroj, který prohledává výsledky soudních sporů a snaží se tak doporučit právníkům, který soudce by mohl být příznivý kterým argumentům.

- Premonition - název tohoto programu v češtině znamená „předtucha“, a to je přesně to, co slibuje: „Dáme vám neférovou výhodu při litigaci.“ Premonition analyzuje výsledky minulých soudů a propočítává, jaké šance by měl ten který případ, pokud by se před soud dostal, což teoreticky může ušetřit miliony dolarů v nákladech na soudní řízení.

Vzhledem k tomu, že právní systémy jsou z logiky věci stále složitější, jen málokterá právní kancelář se může bez podobných nástrojů dlouhodobě obejít. Umělá inteligence ale může v některých případech právníky i zcela nebo částečně nahradit.

Každý může mít „svého“ virtuálního právníka

Nárok na právního zástupce má sice teoreticky každý, v praxi je ovšem rozdíl, jestli vás reprezentuje právník přidělený, nebo právník, kterému platíte dost peněz na to, aby se vám plně věnoval. Zdá se ale, že minimálně v některých oblastech práva si bude moci svého „vlastního“ právníka dovolit každý. Příkladů, kdy umělá inteligence (či dokonce pouze jednoduchý algoritmus) dokáže řešit řadu standardních situací podle šablony, přibývá.

Mladý britský programátor Joshua Browder sestavil konverzačního robota DoNotPay, který dokáže v několika minutách na základě otázek a odpovědí (tedy po chatu) rychle zodpovědět vaše otázky týkající se pokut za parkování nebo zpožděných letů. Dosud pomohl více než dvěma stům tisícům Londýňanů vyhnout se pokutě.

„Běžné případy bude řešit umělá inteligence a lidští právníci se zapojí jen tam, kde to bude nutné.“ Roland Vogl, Stanford University |

Podobných nástrojů bude podle Rolanda Vogla ze Stanfordovy univerzity přibývat, protože poptávka je obrovská: „Každá organizace, která se zabývá právním poradenstvím, musí odmítat nové případy, protože na ně nemá kapacitu. Myslím, že časem bude řada rutinních případů vyřešena počítačovými systémy s umělou inteligencí, a lidští právníci se zapojí jen tam, kde to bude nutné.“

Podle některých kritiků to ale může vést k „explozi nových žalob“. Nyní se do žalob pouštějí lidé s rozvahou, právě kvůli tomu, že jde o náročný proces. Pokud by ale vše od podání žaloby přes předběžné přípravy až po samotný proces zvládl počítačový systém, není problém tyto žaloby škálovat. Programátor a právník Paul Ford tomu říká nanoprávo: „Představte si, že každý den vyřídíte desítky žalob, podobně, jako dnes vyřizujete e-maily.“

Na druhou stranu umělá inteligence a specializované algoritmy by mohly soudům také významně ulehčit. Tento optimističtější pohled zastává třeba Roland Collins, který vyučuje právo na University of Washington. Na příkladu sporů mezi majitelem bytu a nájemníky ukazuje, že roboprávník by mohl urychlit řešení sporu, a to bez toho, aby se vůbec do případu vložil soudce nebo policie. Obě strany by vyplnily dotazník, nahrály by do systému důkazy a poté by nechaly program, aplikaci nebo on-line službu rozhodnout a své rozhodnutí zdůvodnit a podepřít platnými zákony: „Místo toho, aby si najali právníka a pak čekali dlouhé týdny, než se na ně u soudu dostane řada, mohou dostat e-mail s rozhodnutím během pěti minut.“ Ne každá oblast práva je takto jednoznačná, ale Collins věří, že například rozvodové řízení, dědické řízení nebo porušení smluv by počítačový soudce vyřešil stejně dobře jako ten lidský, navíc neskonale rychleji a levněji.

Ještě dále v budoucnu si pak můžeme představit našeho „osobního právníka“, který nejenže reaguje na naše dotazy a pokyny, ale proaktivně hlídá, zda nebyla porušena naše práva. Stejně jako má firma své právní oddělení, které v případě podezření na porušení zákona zašle dopis protistraně, tak by i náš virtuální právník mohl třeba zaslat virtuální „předžalobní výzvu“ firmě, která nás ošidila při vyúčtování nebo sousedovi, který si zapálil na balkoně a porušil tak domovní řád. E-mail se žalobou si ale nepřečte obžalovaný, nýbrž jeho „virtuální právník“, a obě umělé inteligence se pokusí vyjednat řešení. Oba sousedi si spolu mezitím mohou povídat, aniž by tušili, že jeden druhému vyhrožuje žalobou a oba jejich „virtuální právníci“ mezitím v databázích prohledávají padesát let staré precedenty týkající se kouření na balkonech.